Jeśli Twój CISO wciąż próbuje blokować ChatGPT na firewallu, to już przegrał. Przegrał dokładnie jakieś osiemnaście miesięcy temu. Przepaść między wyobrażeniami zarządu a rzeczywistością operacyjną jest już nie do zasypania samą polityką firmy. Podczas gdy 96% kadry zarządzającej przyznaje, że ich struktury zarządzania (governance) nie nadążają za wdrożeniami, 75% pracowników umysłowych już używa AI w pracy. Ale najbardziej obciążającą statystyką nie jest wolumen, lecz typ konta. 73,8% kont GenAI używanych w miejscu pracy to konta osobiste, a nie korporacyjne.

Jeśli Twoja firma należy do tej grupy, Twoi pracownicy prowadzą obecnie ogromne, darmowe laboratorium R&D w godzinach pracy. Przesyłają Twoją własność intelektualną do modeli konsumenckich, bez żadnej suwerenności danych. Twój „zakaz" nie zatrzymał przepływu danych; po prostu zepchnął go do sieci komórkowej i prywatnych urządzeń, gdzie go nie widać.

Pytanie nie brzmi, czy masz w firmie Shadow AI. Pytanie brzmi, czy zbierasz owoce tej innowacji, czy tylko niekontrolowaną odpowiedzialność prawną, udając, że problem nie istnieje i można go rozwiązać samymi procedurami.

Gromadzenie „toksycznych aktywów"#

Korporacyjny firewall, niegdyś symbol kontroli IT, jest dziś zaledwie niedogodnością. Częstotliwość korzystania z narzędzi GenAI wzrosła 61-krotnie w ciągu ostatnich 24 miesięcy. W rezultacie blisko 15% wszystkich promptów wpisywanych przez pracowników zawiera dane wrażliwe lub firmowe.

Kiedy pracownicy używają darmowych wersji ChatGPT, Claude’a czy Gemini do wykonywania swojej pracy, nie tylko łamią politykę firmy; tworzą ryzyka prawne i obciążenia dla Twojej organizacji.

To porażka prawna w trzech wymiarach:

1. Pułapka RODO: „Prawo do bycia zapomnianym" (Artykuł 17)#

W tradycyjnym IT, jeśli przechowujesz dane osobowe bez odpowiedniej zgody, usuwasz wiersz w bazie danych. Problem rozwiązany. Są do tego automatyczne narzędzia.

W przypadku wykorzystania GenAI, gdy pracownik wklei nazwisko klienta do modelu konsumenckiego, dane te zostają probabilistycznie zakodowane w wagach modelu. Nie da się ich „usunąć" bez ponownego trenowania całego modelu — procesu kosztującego miliony. Jeśli klient skorzysta ze swojego prawa do usunięcia danych, spełnienie tego żądania jest technicznie niemożliwe. Organizacja pozostaje w stanie trwałego naruszenia przepisów.

2. Odpowiedzialność „Shadow HR" (Akt o AI)#

Wyobraź sobie menedżera HR, który sfrustrowany wewnętrznymi opóźnieniami, używa darmowego LLM do streszczania i oceny CV. Zgodnie z Załącznikiem III unijnego Aktu o AI, algorytmy rekrutacyjne są klasyfikowane jako Systemy AI Wysokiego Ryzyka (regulacje UE dla systemów wysokiego ryzyka są obecnie odroczone i wejdą w życie prawdopodobnie w 2027 roku).

Używając prywatnego dostępu do LLM, Twoja firma nieumyślnie wdrożyła system wysokiego ryzyka bez oceny zgodności, bez systemu zarządzania jakością i bez rejestracji. Odpowiedzialność za to spada na Ciebie jako podmiot wdrażający (deployer). Potencjalna kara wyniesie do 15 mln euro lub 3% globalnego obrotu, gdy prawo wejdzie w życie.

3. Utrata suwerenności danych#

Darmowe wersje narzędzi niemal zawsze domyślnie kierują wnioskowanie (inference) na serwery w USA. Twoje dane opuszczają UE bez ważnego mechanizmu transferu, naruszając Schrems II. Przykładowo OpenAI zaznacza, że kontrola rezydencji danych to funkcja dla przedsiębiorstw (enterprise), a nie dla konsumentów — i wymaga co najmniej 150 licencji.

Dlaczego nie należy wprowadzać całkowitego zakazu#

Nie możesz zakazać tej technologii, bo jej użyteczność jest po prostu zbyt duża. Twoi pracownicy działają racjonalnie; używają tych narzędzi, bo one działają. Badanie „Jagged Frontier" przeprowadzone przez Harvard Business School i BCG precyzyjnie wyliczyło, co tracisz, egzekwując zakaz:

konsultanci używający AI ukończyli o 12,2% więcej zadań,

pracowali o 25,1% szybciej,

a jakość ich pracy była o 40% wyższa.

Co kluczowe, korzyści były największe dla młodszych stażem pracowników, którzy odnotowali 43% wzrost wydajności.

Działa to jak potężny wyrównywacz szans. Użytkownicy Shadow AI sami szkolą się na „centaurów" — ludzi zintegrowanych z AI — bez korporacyjnego nadzoru. Zakazanie tego jest zarządzaniem ryzykiem, ale jest też dobrowolną decyzją o obniżeniu konkurencyjności Twojej kadry o jedną czwartą.

Amnestia i utwardzanie wytyczonej drogi#

Rozwiązaniem nie jest zaostrzanie zakazów. Jest nim zbudowanie utwardzonej drogi w miejscu wytyczonym przez zastosowania wybrane przez pracowników, która jest bezpieczniejsza i łatwiejsza w użyciu niż “nielegalna” alternatywa.

Faza 1: Amnestia (reset kulturowy)#

Musisz natychmiast wyczyścić „dług zgodności" (compliance debt). CEO (nie CISO) ogłasza 30-dniowe okno „safe haven". Przekaz musi być jasny: „Wiemy, że używacie tych narzędzi, by pracować efektywniej. Chcemy umożliwić korzystanie z tej technologii w bezpieczny sposób. Podzielcie się informacją o narzędziach i przypadkach użycia teraz, a my zapewnimy bezpieczne, zgodne z przepisami narzędzia firmowe i nie wyciągniemy żadnych konsekwencji dyscyplinarnych za dotychczasowe naruszanie polityk".

To zamienia ukryte obciążenie w widoczną mapę aktywów. Odkryjesz „Shadow Agents" — przepływy pracy automatyzujące zapytania SQL, streszczenia prawne czy refaktoryzację kodu — o których istnieniu IT nawet nie wiedziało. To Twój darmowy lab automatyzacji.

Oczywiście to nie jest pełne rozwiązanie dla automatyzacij procesów z wykorzystaniem AI — to nie budowa autostrady, tylko utwardzanie wydeptanych ścieżek, ale od czegoś trzeba zacząć.

Faza 2: Utwardzanie drogi (Architektura AI Gateway)#

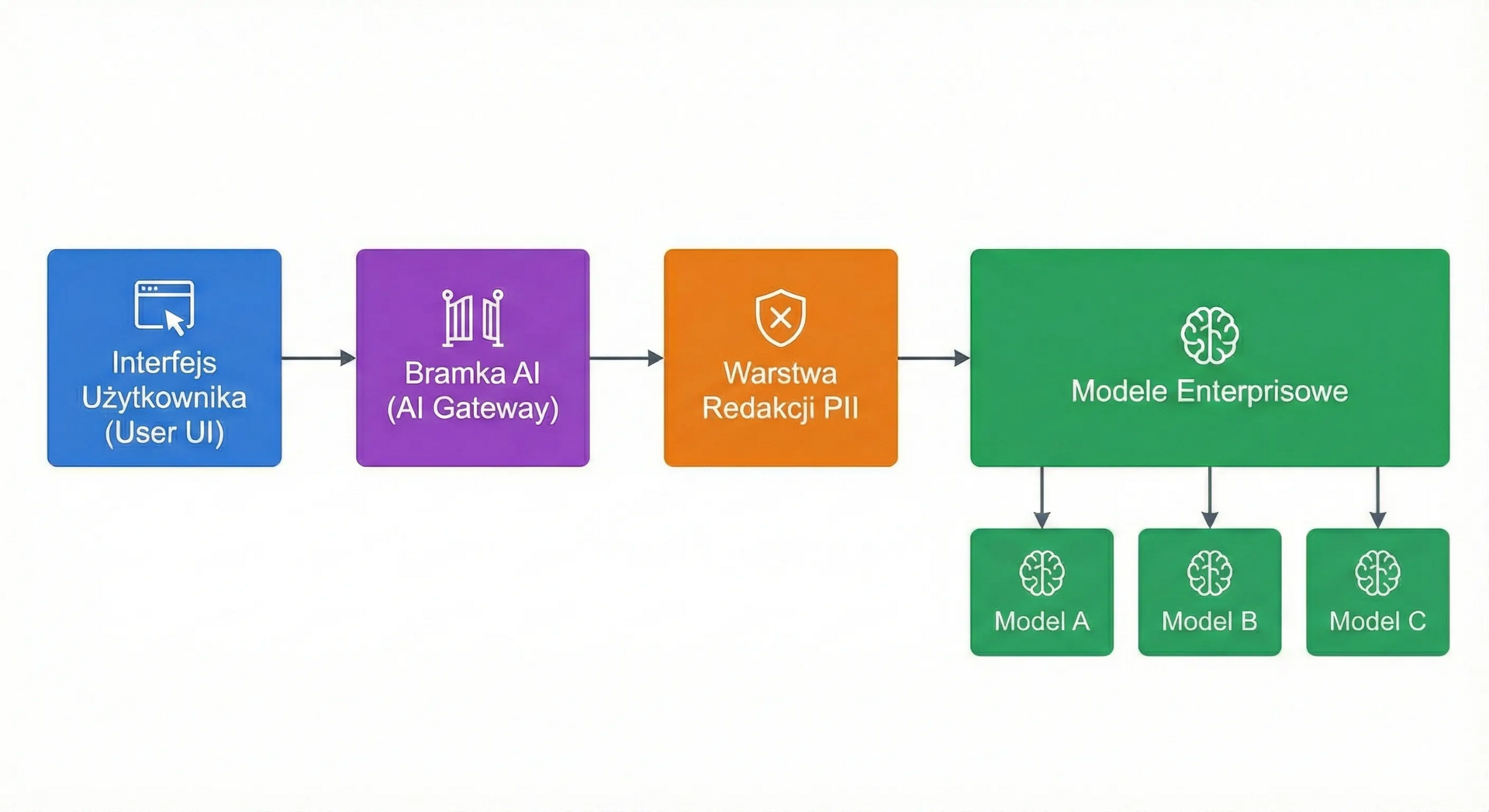

Nie dawaj pracownikom bezpośrednio kluczy API. Nie dodawaj po prostu openai.com do białej listy adresów firmowego firewalla. Musisz wstawić warstwę kontrolną. Rekomendowanym wzorcem architektonicznym jest Enterprise AI Gateway (wykorzystujący narzędzia takie jak LiteLLM, Cloudflare czy Kong).

Architektura:

Ta architektura rozwiązuje problemy prawne bez zabijania produktywności:

Ujednolicony dostęp i API: Pracownicy uzyskują dostęp do jednego wewnętrznego punktu końcowego. Gateway obsługuje routing do Azure OpenAI, Bedrock czy Vertex. Zapobiega to uzależnieniu od jednego dostawcy (vendor lock-in), pozwala na kontrolę kosztów, centralne zarządzanie promptami i kierowanie zapytań do najlepszych narzędzi.

Zapora danych (redakcja): Użyj narzędzi wewnątrz bramki, aby wykrywać i tokenizować dane wrażliwe (numery kart, nazwiska, e-maile), zanim prompt opuści Twoją sieć. Model nigdy nie widzi danych wrażliwych, co neutralizuje ryzyko RODO. Istnieją również narzędzia, które zapewniają maskowanie danych wrażliwych w treściach audio.

Niezmienne logi audytowe: Każdy prompt i odpowiedź są asynchronicznie logowane do Twojego systemu SIEM (np. Splunk). Zapewnia to obowiązkowe „prowadzenie rejestrów" wymagane przez Artykuł 12 Aktu o AI.

⠀

Faza 3: Wdrożenie#

Gdy Gateway już działa, przeprowadzasz zamianę.

Sankcjonowanie: Przypadki użycia o niskim ryzyku i wysokiej wartości otrzymują natychmiastowy dostęp do bramki.

Przełączenie: Użytkownicy ryzykownych narzędzi konsumenckich są migrowani na instancję firmową.

Zatrzymanie: Dopiero wtedy blokujesz pozostałe narzędzia wysokiego ryzyka i o niskiej wartości.

Dostawcy rozwiązań bezpieczeństwa sprzedają blokady — narzędzia sieciowe, które tworzą iluzję kontroli, podczas gdy pracownicy je omijają. Celem jest budowanie ścieżek. Podejście oparte na utwardzaniu ścieżek zachowuje wzrost produktywności, jednocześnie mitygując ryzyka prawne.

Dodatkowo, wdrożenie dostępu do modeli AI jako rozwiązania ogólnofirmowego umożliwia korzystanie z tych narzędzi osobom, które do tej pory tego nie robiły, bo przestrzegały polityk bezpieczeństwa, oraz szerzy w organizacji wiedzę o AI.

Briefing#

Rachunek za „lukę w nadzorze"#

Raport IBM Cost of a Data Breach Report 2025 wycenia nasze zbiorowe zaniedbanie na: 670 000 USD. To średni dodatkowy koszt naruszenia danych dla organizacji z wysokim poziomem Shadow AI w porównaniu do tych bez niego.

Raport identyfikuje krytyczną lukę w nadzorze AI. Podczas gdy adopcja przyspiesza, zarządzanie utknęło w martwym punkcie. 63% organizacji, które doświadczyły naruszenia, nie miało żadnej polityki zarządzania AI, a 97% naruszeń związanych z AI dotyczyło systemów z niewłaściwą kontrolą dostępu. Wdrażamy szybciej, niż zabezpieczamy.

Co istotne, raport podkreśla rozdwojenie rzeczywistości. AI jest zarówno trucizną, jak i antidotum. Podczas gdy Shadow AI generuje koszty i ryzyka, organizacje szeroko wykorzystujące AI do bezpieczeństwa (wykrywanie i reagowanie) zaoszczędziły średnio 1,9 miliona USD na naruszeniu i identyfikowały zagrożenia o 80 dni szybciej.

Przekaz jest jasny: AI nie jest opcjonalną warstwą, którą można zignorować. Używana defensywnie, jest Twoją najsilniejszą tarczą; pozostawiona bez nadzoru w cieniu, jest czekiem in blanco dla atakujących.

Historia nie tylko z książek#

Niedawny incydent omawiany w kręgach cyberbezpieczeństwa potwierdza, że nie jest to teoretyczne ryzyko wymyślone przez konsultantów. CISO zgłosił odkrycie, które „mrozi krew w żyłach": młodszy programista, męcząc się z debugowaniem zapytania SQL, wkleił ponad 200 rekordów klientów (w tym e-maile i numery telefonów) bezpośrednio do ChatGPT.

Programista nie miał złych intencji; po prostu próbował wykonać swoją pracę. Przerażająca część? CISO dowiedział się o tym tylko dlatego, że przechodził obok jego stanowiska. System DLP (zaprojektowany dla załączników w e-mailach) był całkowicie ślepy na wklejanie tekstu w przeglądarce.

To jest shadow AI w działaniu. Pracownik rozwiązał swój problem w kilka sekund, ale robiąc to, przekazał schemat bazy danych firmy i dane wrażliwe do publicznego modelu. Żadna polityka temu nie zapobiegła. Żaden firewall tego nie zatrzymał. Tylko architektura „utwardzonej drogi" — zapewnienie dostępu do bezpiecznego narzędzia — mogła temu zapobiec.

Podsumowanie — Pytanie na poniedziałkowy poranek#

Podczas najbliższego przeglądu bezpieczeństwa lub zgodności, zadaj swojemu CISO lub Inspektorowi Ochrony Danych to jedno pytanie:

„Biorąc pod uwagę, że nie możemy usunąć naszych danych z wag modelu OpenAI, czy mamy wiarygodną metodę, by udowodnić, że żaden pracownik nie wkleił listy klientów do darmowego ChatGPT sześć miesięcy temu?"

Jeśli nie potrafią odpowiedzieć na to pytanie jednoznacznie, to znaczy, że polityka AI jest kocykiem bezpieczeństwa. Twoja organizacja buduje ekspozycję na ryzyko, której nie widzisz i której możesz nie być w stanie naprawić.

Jeśli chcesz przejść od zakazów do kontrolowanego wdrożenia — porozmawiajmy. Pomogę Ci zbadać, jak AI jest już używana w Twojej organizacji, i zbudować bezpieczną ścieżkę dalej.

Do następnego razu, Krzysztof